Start » Blog » Analytics / Google

04.06.2012

Analytics Content Experiments: (noch) schlechter Ersatz für Google Website Optimizer

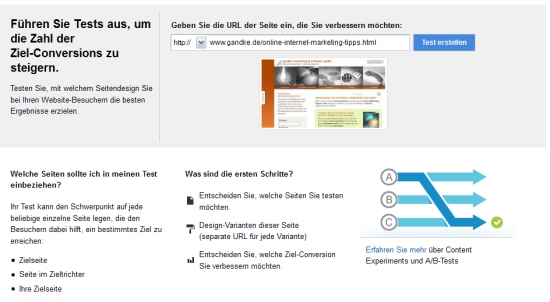

Mit großem Trara beerdigt Google zum 1. August den Google Website Optimizer und bietet als Ersatz neue "Content Experiments" in Google Analytics an. Wer sich nur die Ankündigungs-E-Mail von Google dazu durchliest könnte meinen, es handelt sich um alten Wein in neuen Schläuchen und das Tool sei nur "umgezogen". Die dort verwendete Formulierung "To elevate website optimization and provide one fully integrated tool for testing, content optimization will now have a new home within Google Analytics." klingt ja auch vollmundig und lässt auf Umsetzung vieler Wünsche hoffen, die man ggf. bisher im Einsatz des Website Optimizers entwickelt hat.

Mein erstes Fazit lautet aber leider: Pustekuchen. Es sind zwar ein paar erfreuliche Vereinfachungen mit dem Umzug gekommen, aber leider auch eine Menge Einschränkungen. Die überwiegend guten Nachrichten daher lieber zuerst.

Das mag (meistens) nett sein:

- Ein separates Script für eine Conversion kann man sich nun i. d. R. sparen, denn es werden Analytics-Ziele als Grundlage für einen Test verwendet. Da dieser Punkt aber auch bedeutet, dass man für bisher per Script herbeigeführte Extrawürste wie Auslösen einer Conversion nach Erreichen einer Mindestanzahl von "Microconversions" o. Ä. nun ggf. (temporäre) "Hilfsziele" einrichten muss, muss das nicht zwingend ein Vorteil für jeden Anwendungsfall bedeuten. Zumindest aber geht dadurch keine Flexibilität verloren, macht bestimmte Szenarien nur ggf. etwas umständlicher oder erfordert (wenn alle Ziele "belegt sind") evtl. sogar ein neues Profil für Tests (zumal die Anzahl der Tests pro Profil in Analytics nun auf 12[wieso 12?] begrenzt ist)

- Überhaupt werden weniger Scripts in Seiten benötigt, denn auch die Varianten müssen nicht mehr separat verwanzt werden, sondern nur noch die Originalseite. Klingt gut. Das "Aber" kommt dann nachher in der nächsten Liste...

- Google steuert den Traffic auf die Varianten "schlau" selbst. Ziel ist es hier, die Seiten mit offenkundig schlechterer Konversionsrate nach einer gewissen Sicherheit mit weniger Traffic zu beschicken, um den Schaden für die Website zu minimieren. Klingt erst einmal gut, bedeutet aber durch die zwingende Nutzung dieser nicht-optionalen "Gutwillensautomatik" in gewisser Weise auch Kontrollverlust beim Experiment.

- Wollte man bisher die Besucher einer bestimmten Variante separat in Analytics auswerten, musste man diese explizit mit einer benutzerdefinierten variable zu diesem Zweck markieren und konnte so Segmente bilden. Das ist jetzt durch die Integration einfacher, so dass das Verhalten jenseits der reinen Zielerreichung durch Segmentierung nach Varianten leichter beobachtet werden kann. Spart aber grundsätzlich erst einmal nur (geringen) Aufwand beim Aufsetzen es Experiments im Vergleich zur alten Lösung

- Adieu Langzeittests: Tests in Analytics enden spätestens nach 3 Monaten. Das ist prinzipiell mal ein Vorteil, denn so ist man gezwungen, sich von der Idee zu verabschieden, einen Test nur lange genug laufen lassen zu müssen, um einen Gewinner zu finden, obschon die getesteten Variablen offenbar überhaupt keinen Einfluss auf die Ergebnisse des Tests haben ;). Das das im Einzelfall aber auch wieder ein Nachteil sein kann, ist ja fast schon klar...

- Keine kollidierenden Tracker-Objekte mehr. Wer bisher GA und GWO parallel genutzt hat, musste ggf. die Scriptcodes anpassen, damit der Spaß überhaupt funktioniert. Außerdem wurde auf diese Weise auch mehr Code angezogen und ausgeführt, als das jetzt der Fall zu sein scheint, da keine zwei "Analytics-Codes" und unterschiedliche Profile mehr im Spiel sind. Die Content Experiments funktionieren sowohl mit dem neuen, als auch dem alten (synchronen) Trackingcode.

Das war es aber eigentlich auch schon. Ein wenig schöner mag das UI durch die Integration in Analytics ja geworden sein, aber wesentlich und / oder besonders bemerkenswert (weil nun einfacher oder besser oder sonstwas) finde ich das nicht. Mit Tools wie Optimizely hat man damit jedenfalls noch lange nicht aufgeschlossen. Vielmehr scheint es schon jetzt einige leicht zu identifizierende Nachteile zu geben... und es steht zu befürchten, dass mit steigender Erfahrung mit dieser Integration (noch ist kein einziger Test, der hier in Analytics gestartet wurde, bereits beendet) noch weitere Punkte dazu kommen werden.

Nicht so schön:

- Der wichtigste Punkt zuerst: Die Flexibilität wird damit stark eingeschränkt. Denn sowohl (wie bisher dynamisch generierte) Multivariate Experimente als auch Experimente mit mehr als 5 Varianten sind mit den Content Experiments in Google Analytics nicht umsetzbar. Mehr muss man dazu auch eigentlich nicht schreiben, aber es ist eine wirklich fette Kröte, die man damit schlucken muss und ich würde mich nicht wundern, wenn das im ersten Schritt den Wettbewerb mehr stärkt, als dass es Analytics-Benutzer neu auf das Thema "Testing" bringt...

- Ein Punkt, den viele sicher auch der Liste der Vorteile zuordnen würden: Es dauert mindestens 2 Wochen, bis ein Test "sichere" Ergebnisse liefert. Ob dies nun wirklich dazu dient, voreilige Schlüsse zu vermeiden oder nicht: Wer wirklich Traffic hat, konnte bisher nach Ablauf von mindestens 7 Tagen (um Schwankungen im Wochenverlauf nicht zu ignorieren) oftmals bereits fertig sein. Natürlich: Google zeigt wie früher stets den aktuellen Stand der Dinge an und verbietet auch nicht, einen Test "vorzeitig" zu beenden, aber es ist zu erwarten, dass eine Vielzahl von Benutzern erst dann Vertrauen in ein Ergebnis hat, wenn auch das Tool sagt, dass es "fertig" ist...

- Folgetests auf der gleichen Seite erfordern offenbar stets einen neuen Code, denn jeder Test hat eine eigene ID

- bei einer Implementierung in die Webanalyse naheliegende Wünsche wie die Beschränkung der Teilnahme an Tests nach verschiedenen Segmentierungskriterien o. Ä. sind (noch) nicht umgesetzt. Das bedeutet, dass die Integration in Analytics bis auf die Verwendung von dort bereits definierten Zielen noch keine der erwarteten funktionalen Verbesserungen mit sich gebracht hat. Auch die Berücksichtigung mehrerer Ziele o. Ä. (sei es gewichtet oder nicht) bleibt so folgerichtig noch offen

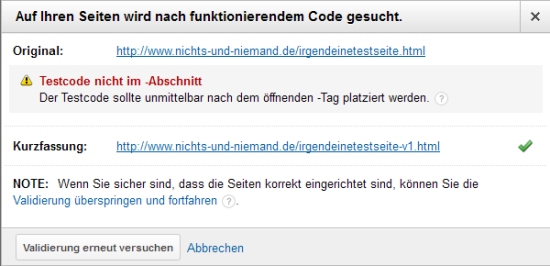

- Die Validierung ist noch zickiger als bisher. Wenn man das Script in der Originalseite z. B. nun nicht direkt nach dem head-Tag einfügt, gibt es Gemecker.

Das bedeutet zwar nicht, dass man das Script nicht genau wie vorher zur Not (wenn es das CMS z. B. nicht anders zulässt) an anderer Stelle unterbringen, die Meldung ignorieren und trotzdem Ergebnisse erhalten kann, aber aus Sicht des typischen Analytics-Anwenders ist das vielleicht schon ein Grund, bereits nach dem ersten Einrichtungsversuch dauerhaft das Handtuch zu werfen - Die Integration wirkt teilweise noch fehlerbehaftet. Ob z. B. Vorschaubilder der beteiligten Seiten dargestellt werden oder nicht, scheint noch dem Zufall unterworfen zu sein. Das sind zwar Kleinigkeiten und zumindest bis jetzt scheinen Tests durchaus zu funktionieren, aber auch das fördert normalerweise nicht das Vertrauen der potentiell durch die Integration neu zu gewinnenden Benutzer für diese Funktion

- Wer wirklich viel testet, wird sich vermutlich schnell über die Limitierung auf 12 Tests pro Profil ärgern. Damit sind übrigens aktive Tests gemeint. Wenn ein Test also abgelaufen oder pausiert ist, zählt er nicht für dieses Limit

Also: Luft nach oben ist noch reichlich vorhanden. Es bleibt zu wünschen, dass zumindest wesentliche Funktionen wie multivariate Tests möglichst schnell wieder einen Weg in das Tool finden, denn ansonsten ist es absehbar, dass es sich für eine ganze Menge typischer Testszenarien vorerst disqualifiziert. Warum der GWO zumindest in der Übergangsphase nicht weiterhin verfügbar bleibt, muss man Google fragen. Es sei denn, die größten Lücken werden noch vor dem 1. August geschlossen. Wer weiß..?