Start » Blog » Analytics / Toolcheck

21.09.2018

Nacho Analytics: Same Shit, Different Can

Als ich vor ein paar Wochen erstmals den Namen "Nacho Analytics" gehört hatte, bin ich sowohl neugierig als auch skeptisch geworden. Das Tool verspricht dem Nutzer, in "jedermanns Analytics" schauen zu können. Einfach so. Revolutionäre Idee, mega-innovativ, Blabla.

Zugegeben: Kaugummigestützt aus "Not Your Analytics" ein "Nacho Analytics" zurechtzunuscheln, ist schon mal eine kreative Idee (die nur ein Amerikaner haben konnte). Und die verfügbaren Daten in Analytics zu versenken, klingt im ersten Moment auch nicht dumm. Aber steckt mehr dahinter, als durch pluginverseuchte Browser gesammelte Daten wie im Fall von SimilarWeb? ich wollte es wissen und habe nach längerer, durch gutes Marketing und schlechte Skalierung beim Anbieter ausgelöster Wartezeit einen kurzen Test gemacht, um mir einen Eindruck zu verschaffen.

Was macht Nacho Analytics - und wie?

Kurz gesagt: Es werden Daten gesammelt, indem Sitzungen echter Besucher der betreffenden Website über installierte Plugins mitgeschnitten werden. Diese Daten werden dann "aufbereitet" und über das Google Analytics Measurement Protocol an eine Analytics-Property gesendet, um sie dort als Nutzer des Tools auswerten zu können. Hier lohnt sich vermutlich ein kleiner Einschub:

Wir alle sind potentiell Teil des "Panels"

Diese Art der "panelbasierten" Datenerhebung im Browser ist nichts Neues - das passiert schon seit vielen Jahren. Viele Nutzer Browsern wie Firefox und Chrome ermöglichen es den Datensammlern, die hinter verschiedensten populären Plugins stecken, jede besuchte URL (und theoretisch natürlich auch vieles mehr) mitzuschneiden und zu Auswertungszwecken wie eben der Analyse der Nutzung einzelner Websites zu sammeln. Plugins sind damit also die Erben der "Alexa Toolbar" und ähnlicher Instrumente, die diese Aufgabe in der Vergangenheit übernommen haben.

Dass die Website-Besucher dabei helfen, diese Daten zu erheben, ist diesen i. d. R. nicht bewusst. Wer liest schon, was ein Plugin so alles macht? Und wer vermutet schon, dass Erweiterungen für Browser, die Screenshots anfertigen, Bookmarks synchronisieren oder Sites wie Instagram, Facebook & Co. um zusätzliche Funktionen erweitern, mehr tun als die Erfüllung dieser Kernfunktion? Genau - wenige. Wie so oft bezahlt man die kostenlosen Helfer mit "seinen" Daten. Das ist i. d. R. auch entweder schon bei der Entwicklung des Plugins heimlicher Hauptzweck oder ein interessierter Datenverkäufer erwirbt ein populär gewordenes Plugin vom Entwickler und rüstet die Datenschnüffelei später nach. Nicht alle Daten laufen in eine Hand, aber Anbieter wie Nacho Analytics oder das o. g. - und deutlich kostspieligere - SimilarWeb kaufen diese Daten dann aus verschiedenen Quellen ein und erheben vermutlich auch über eigene Plugins selbst einen Teil, um diese dann weiterzuverarbeiten und in ihren Kunden zur Auswertung zur Verfügung zu stellen.

So kommen dann durchaus nennenswerte Daten zusammen, wenn eine Website eine gewisse Anzahl an regelmäßigen Besuchern verzeichnet. Aber auch bei stets mehreren tausend aktiven Plugins, über die auf diese Weise Infos über besuchte URLs gesammelt werden, ist nicht für jede Website ausreichend Material zu bekommen, um daraus Schlüsse zu ziehen. Ein weiterer Nachteil, den wir hier in Europa immer bei dieser Methode haben werden, ist die Konzentration auf den englischsprachigen Markt. Natürlich werden auch hier entsprechende Plugins eingesetzt. Mitunter sind auch bekannte und weit verbreitete Erweiterungen wie z. B. das beliebte "Ghostery" dabei, so dass man auch jenseits der USA Sitzungen mitbekommt, aber für eher auf Deutschland ausgerichteten Websites wird auf diese Weise stets weniger zusammenkommen, als für US-Sites oder globale Kandidaten wie ebay o. Ä.

Hat er gerade "Ghostery" gesagt? Ja, aber natürlich! Das Ding schaut den Anwendern dabei zu, wie sie Sites besuchen, auf denen sie nicht getracked werden wollen und selbstverständlich sind die hierbei website-übergreifend mitgeschnittenen besuchten URLs - und auch die bei Google & Co. eingegebene Suchbegriffe etc. - die Währung, mit der der Anwender für den Einsatz bezahlt. ob diese Daten auch in Nacho Analytics oder SimilarWeb einfließen? Keine Ahnung. Aber sie werden auf jeden Fall auch im Fall von Ghostery erhoben (ich habe gefragt! ;)) und so eben sicher auch auf die eine oder andere Weise wie oben beschrieben genutzt.

Google Analytics als UI bei Nacho Analytics - clever?

Zurück zu Nacho Analytics: Wer sich für das Besucherverhalten einer fremden Website interessiert, kann bei Nacho Analytics die wie oben beschriebenen Daten der betreffenden Site im Rahmen eines bezahlten Zugangs erhalten. Diese werden nicht wie bei SimilarWeb (soweit ich das Tool kenne) in einer eigenen Auswertungsoberfläche des Anbieters bereitgestellt, sondern der Nutzer von Nacho Analytics legt sich eine neue Property bei Google Analytics an und die Daten der gewünschten Website werden dann dort über das Measurement Protocol eingespielt.

Dort kann man sich dann mit den vertrauten Funktionen in "fremden Daten" umsehen und daraus idealerweise auch seine Schlüsse ziehen. Auch andere Tools machen das und nicht immer finde ich das angemessen, aber in diesem Fall ist es doch kein schlechter Ansatz - man vermeidet sowohl die Notwendigkeit, sich in eine andere Oberfläche und deren Funktionen einzuarbeiten und kann dem Benutzer zugleich die ganze Vielfalt an Reports aus GA bieten, ohne diese selbst nachbauen zu müssen. Insofern also: Ja, clever. Allerdings gibt es natürlich reichlich Lücken in den Daten und da steckt (eigentlich immer in solchen Fällen) mein Hauptkritikpunkt. Wer Google Analytics als Nutzer kennt und für die eigene Website nutzt, hinterfragt ggf. die Unterschiede nicht, die in einer so generierten und extern gefütterten Property zwangsläufig stecken. Deshalb ist das auch ein guter Zeitpunkt, auf diese Unterschiede bzw. Mängel einzugehen.

Wie vollständig sind die Daten?

Oben schon beschrieben kann man nicht erwarten, wirklich alle Daten aller Besucher zu sehen.

- Die Methode der "Erhebung" erfordert die Nutzung entsprechender Erweiterungen im Browser und das sind nun mal nie 100% (und auch 50% sind vermutlich sehr sehr unrealistisch).

- Auf diese Weise fallen z. B. auch alle mobilen User aus der Betrachtung, denn hier sind i. d. R. keine Plugins installierbar.

- Das allein macht aber noch nicht den Unterschied aus, denn eine typische Analytics-Implementierung besteht aus mehr als nur dem Mitschnitt besuchter URLs.

- Events, Transaktionen etc. sind so nicht zu vermessen. Im besten Fall gibt es echte konkrete URLs, anhand derer man einen Erfolg wie einen Kauf, eine Anmeldung o. Ä. erkennen kann, so dass man zumindest Ziele einrichten kann (wenn man sich ausreichend mit der untersuchten fremden Website befasst hat), aber Umsätze wird man nicht sehen.

- Auch weiterführende - und oft wesentliche - Dinge wie Benutzerdefinierte Dimensionen, Contentgruppierungen etc. können auf diese Weise natürlich nicht so erhoben werden, wie es der Betreiber der Website mit seinem Trackingcode kann.

- Man sieht stets nur die realen URLs aus dem Browser. Das ist nicht immer das, was man selbst an Analytics sendet. Stichwort: Konsolidierung von URLs, virtuelle Seitenaufrufe etc.

Auf diese Weise ergeben sich folgerichtig auch weitere Lücken in den Reports, denn man greift freilich weder auf den Analytics Cookie zu (was zu Unterschieden in der Anzahl der User, Sessions / User etc. führt), noch kann man die Demografie des Besuchers bestimmen (wie es mit den erweiterten Werbefunktionen in GA möglich ist). So sind also gerade aus dem Bereich "Zielgruppe" in Analytics viele Berichte leer oder irreführend, wie im Fall von Browser und Betriebssystem: Man sieht eben nur Chrome und Firefox auf Windows, Linux oder Mac; alles andere ist unsichtbar.

Bei Nacho Analytics geht (Update: die Inhalte sind inzwischen - wie der Dienst auch - erfreulicherweise nicht mehr zu haben) man auch (weit unten auf der Seite ;)) recht offen mit dem Thema bei der Erklärung der Funktionsweise um - zumindest, was mobile Besucher angeht. Der Tatsache, dass man nicht alle Besucher erfassen kann, begegnet man offenbar mit irgendeiner Form der Hochrechnung. Wenngleich man hier auf "AI" und "Machine Learning" in der schwammigen Formulierung verzichtet hat: "To make the truest traffic estimates, we use actual website visitor data to model activity on a larger scale.". Wie auch immer das also passiert, man schickt offenbar mehr als nur die gesammelten Daten in die Auswertungs-Property. Hier steckt dummerweise der Haupthebel, wenn es darum geht zu bestimmen, wie gut oder schlecht die für den Nutzer des Tools verfügbaren Daten stecken. Und es ist ausreichend unklar, wie gut oder schlecht dieser genutzt wird 😉

Ergebnisse meines (kurzen) Tests

Nach einiger Wartezeit nach dem ersten Ansturm, der zu einer Anmeldezwangspause geführt hatte und einem zwischenzeitlichen Entfall einer echten Testphase durfte ich mich doch noch ohne vorherige Belastung der Kreditkarte für maximal sieben Tage im Tool umsehen und habe die Gelegenheit genutzt.

Meine ersten Versuche, eigene Websites hier einzutragen, sind alle mit der Meldung quittiert worden, dass man dafür zu wenig Daten habe. Sprich: Viele (hiesige) Sites haben zu wenig Traffic, um unter das Marketingversprechen "See anyone's Real-Time Analytics" einzulösen. Das tut weh. Ich habe also ersatzweise die Site eines Kunden genutzt, der mir einen Analytics - Zugriff gewährt hat, damit ich reale Analytics-Daten mit den Ergebnissen von Nacho Analytics vergleichen kann... soweit mir dies unter den o. a. Rahmenbedingungen und angesichts der Unterschiede sinnvoll erschien.

Echtzeit? Nope!

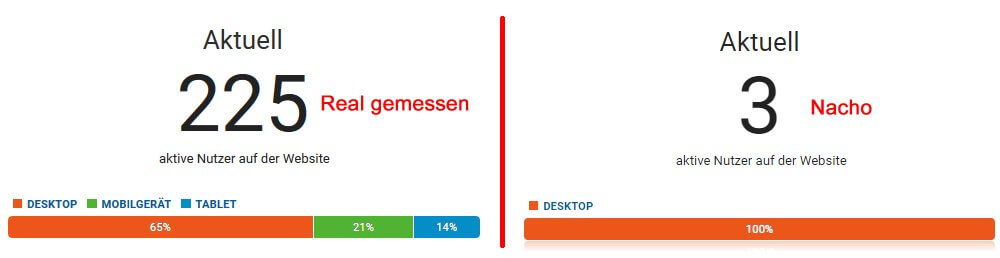

Um Fair zu bleiben, habe ich in den realen Daten zunächst nur auf ein Segment geschaut, das ausschließlich Chrome und Firefox auf dem Desktop beinhaltet. Da aber ja explizit von "Real Time" die Rede war, habe ich natürlich auch da nachgesehen, was also nichts mit Segmenten zu tun hat. Meine erste Überraschung: Während die echte Webanalyse aktive 184 Besucher zeigte, fand ich im "Nacho-Profil" immerhin satte 46 User! Da war ich erst einmal überrascht von der offensichtlich hohen Abdeckung. Auf den zweiten Blick war das aber ein Trugschluss, denn die vielen Besucher hatten ihren Ursprung vermutlich darin, dass bei der "Erstbestückung" mit Daten eben sehr viele Sitzungen erzeugt werden, bis alles, was man schon für den laufenden Tag zu bieten hatte, erst einmal "eingeschossen" war. Ein Vergleich zu einem späteren Zeitpunkt fällt folgerichtig ganz anders aus:

Wenn man nur nach diesen Daten geht, hat man also 3 von etwa 146 (65% Desktop von 225 Gesamt) Besuchern "abgedeckt". Ist dieser Anteil belastbar? natürlich nicht. Manchmal sind es auch 24 von 170 oder einer von 96... so oder so aber nicht zu gebrauchen. Auch weiß man nicht, wie zeitnah nach der Erstbestückung neue Daten per GAMP in Analytics geschaufelt werden. Bleiben wir bei der Feststellung, dass wir "Real Time" ebenso aus dem Claim schmeißen können wie "anyone´s". Übrig ist also nur noch "See Analytics [if we think we have enough data]". Klingt natürlich nicht ganz so catchy... und war auch genau das, was man erwarten kann, wenn man die Methode der Datenerhebung kennt. Bleibt die Frage, wie vergleichbar denn das ist, was man bekommt.

Zielgruppe... besser nicht!

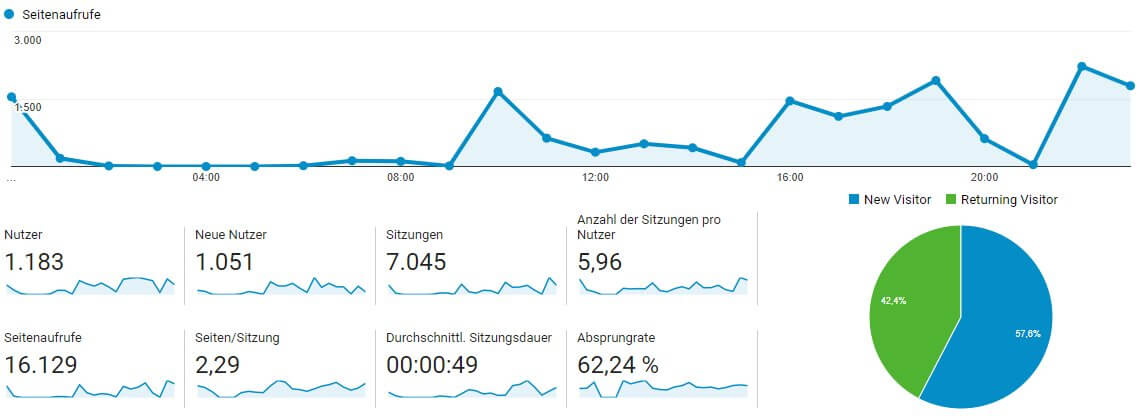

Die erste Antwort, die ich dazu gesucht habe, ist die Übersicht. Mit allen Schwächen, die man hier bei einer Betrachtung des "ganzen Breis" über alle Besucher hinweg in Kauf nehmen muss. Es bleibt ja interessant zu sehen, wie sowohl die Anzahl der Seitenaufrufe als auch die Kennzahlen wie Seiten / Besuch, Besuchsdauer etc. zusammenpassen. Ich habe mich dabei auf die Daten eines einzelnen Tages gestützt (der Test dauerte ja nur ein paar Tage).

Das Ergebnis ist ... naja... ernüchternd. Lt. Nacho Analytics war das hier los an besagtem Tag:

Für das besagte Segment der Firefoxe und Chromes, die an diesem Tag auf dem Desktop gemessen wurden, weist Google Analytics diese Zahlen aus:

Wer diese Unterschiede sieht, hat eigentlich keinen Bock mehr, weiter in den Zahlen zu graben. Versuchen wir dennoch eine Interpretation: Die deutlich höhere Anzahl der Sitzungen / User bei Nacho kommt vermutlich davon, dass man die gleiche User-ID nutzt, wenn man gesammelt Hits überträgt, die von "vergleichbaren" Besuchern kommen, also z. B. Chrome-User aus der gleichen Region. Solange man keine Dimensionen wie Mobilfunkanbieter, Betriebssystem, Sprache o. Ä. unterschiedlich gestalten muss, wird also vermutlich der gleiche User "genutzt", um die Daten an Analytics zu übergeben. Das ist freilich großer Käse, wenn es um Kennzahlen geht, die Besucher und Ihr Verhalten auswertbar machen sollen. Alle anderen Reports aus dieser Gruppe leiden also zusätzlich zu den o. a. Einschränkungen auch noch an dieser Verzerrung. Auch die Sitzungsdauer scheint ein Problem zu sein, also hat man entweder keine Zeitstempel gesammelt oder vergessen, diesen Aspekt bei der Bestückung der Property zu berücksichtigen. Machbar wäre es jedenfalls. Und wenn man "absolute Zahlen" vergleicht, scheint entweder keine Hochrechnung von Sitzungen stattzufinden und man sieht nur das, was tatsächlich an Daten erhoben wurde - oder die Hochrechnung ist genau so zuverlässig wie der Rest der Zahlen (also eher wie Loki und weniger wie Thor).

So kann man bestenfalls bestimmen, aus welcher Region - vermutlich - die meisten Besucher einer Website kommen. Das kann man aber i. d. R. auch ohne solche Tools, wenn man sich die Website selbst nur etwas genauer anschaut. Ich sehe keinen echten Mehrwert, mag aber zu kurz gedacht haben und lasse mich gern vom Gegenteil überzeugen.

Akquisition? Hat Potential. Und Probleme.

Woher kommt denn der Traffic von Wettbewerber 123? Das ist natürlich eine interessante Frage, die ggf. ja unabhängig von obigen Mängeln beantwortet werden kann. Von Kanalgruppierungen und anderem Kleinkram angesehen sollte man doch zumindest einen groben Eindruck der Verteilung nach verschiedenen Quellen und Medien bekommen können, schließlich sieht der Browser ja die UTM-Parameter aus den URLs und kennt auch die verweisende Seite oder Suchmaschine... und sogar die Suchbegriffe. Wird es hier also besser?

Leider nicht - jedenfalls nicht in diesem Fall. Denn an erster Stelle stehen Sitzungen, deren Quelle die eigene Website ist (und die ich hier mit "beispiel.de" ersetzt habe. Hier stand aber genau die Domain, die ausgewertet werden soll). Ich habe mich mal auf die Top 3 (also hier zwangsweise 4) beschränkt.

Wie kann denn das passieren? Wie verweist eine auf diesem Weg "extern vermessene" Website auf sich selbst? Die Antwort: Gar nicht. Aber beim Bestücken der Auswertungs-Property scheint man sich nicht viel Mühe mit dem Nachbilden von Sessions gegeben zu haben und / oder es wurde bei der Gestaltung der Hits schlichtweg geschlampt. Was das eigentliche Problem dabei ist: Wenn über ein Drittel der ohnehin schon nur als Stichprobe erhaltenen Daten falscherweise in "Selbstverweis-Sessions" landet, ist der ganze andere Kram eigentlich auch nicht mehr zu gebrauchen. Dennoch der Vollständigkeit halber hier die entsprechenden Zahlen aus Analytics:

Wie man sieht, sieht man nichts. Es sind keine belastbaren Trends zu erkennen und die Verteilung der Quellmedien untereinander ist auch komplett willkürlich. Dennoch kann man mit den Daten etwas anfangen. Beispiele:

- Erkennung von Kampagnenparametern erlaubt zumindest einen Einblick in die Marketingaktivitäten

- Verweistraffic, der hier ausgewiesen wird, findet (mit Ausnahme der Selbstverweise) tatsächlich statt.

- Mit Abstrichen: Laufzeit und Frequenz von Kampagnen identifizieren, wenn man längere Zeiträume auswertet

Man kann also Quellen durchaus erkennen... nur deren tatsächlichen Anteil am Traffic offenbar nicht zuverlässig (wenn die Datenbasis so "gering" ist, wie bei der hier getesteten Domain. Das ist aber keine Frittenbude und es gibt durchaus nennenswerte Besucherzahlen, wie aus dem o. a. Ausschnitten erkennbar ist). Auch hat die Auflistung hier keinen Anspruch auf Vollständigkeit. Am hier untersuchten Stichtag sind aber immerhin 15 von 95 verschiedenen Quellmedien-Kombinationen erkannt worden. Auswertungen über längere Zeiträume werden daher sicher Einsichten liefern können, die man ohne dieses Mittel nicht oder nur durch aufwändiges Monitoring von typischen Marketingaktivitäten erhalten kann.

Bring Back The Keywords?

Einer der potentiellen Vorteile dieser Lösung sollte es sein, dass man nach einem Klick auf den Eintrag für die organischen Besucher auch Keywords sehen sollte - schließlich war das Plugin ja dabei, als die Suche durchgeführt wurde. Aber auch in diesem Punkt muss ich leider "Essig" vermelden. Von knapp 500 Besuchen aus google / organic sind 450 ungeachtet dessen "not provided". Warum? Keine Ahnung. Vielleicht sind es auch nur 50 reale Besuche gewesen und der Rest liegt wieder an der verqueren Zuordnung von Sitzungen. Ich hatte jedenfalls mehr erwartet.

Verhalten: Hmpf.

Wie sieht es denn mit den Top-Seiten aus? Und die Einstiege und Ausstiege? Was den Bericht "Alle Seiten" angeht, so ist die Story schnell und ohne Bilder erzählt: Von ca. 22.000 URLs im "echten" Bericht findet die Nacho-Kopie knapp 700. Deren Top 10 sehen so unterschiedlich aus, dass ich nicht einmal mit Mühe und gutem Willen etwas damit anfangen kann. Nicht man die Aufrufe der Startseite kommen einigermaßen passend davon, wenn man die Zahlen im Verhältnis sieht. Wer sich auf diesen Bericht verlässt, ist also - zumindest in meinem Fall - vollkommen auf dem Holzweg. Aber auch hier gilt, dass bei mehr mitgeschnittenem Traffic auch bessere Ergebnisse denkbar sind. Etwas besser sieht es aus, wenn man die Auswertung nach der ersten Seitenpfadebene betrachtet.

Zielseiten oder Ausstiegsseiten? Wer die ganzen Selbstverweise oben noch im Kopf hat, der vermutet auch hier ganz richtig, dass nur Mist rauskommt. Das ist aber kein Wunder, wenn die Sessions so willkürlich durcheinandergewürfelt werden.

Bleibt noch die Site Search. Und hier findet man - wenngleich natürlich mit allen schon genannten Einschränkungen - vermutlich tatsächlich interne Suchbegriffe, wenn die Suche anhand der URL auswertbar ist, was ja durchaus bei vielen Websites der Fall ist - man muss das aber natürlich wie bei einer echten Analytics-Installation vorher herausfinden und in der Konfiguration berücksichtigen, bevor man sich die Daten senden lässt. ich konnte das bei meinem Testkandidaten leider nicht erproben.

Funfact: Ich habe während der Testlaufzeit aus verschiedenen Browsern und mit unterschiedlich mutiger Auswahl an Plugins versucht, meine eigenen Aufrufe der Testwebsite in den Berichten der Nacho Analytics Property zu finden, indem ich bestimmte URLs aufgerufen oder harmlose Parameter angehängt habe. Das ist gescheitert, muss aber nicht bedeuten, dass meine Daten nicht trotzdem "irgendwie" verarbeitet wurden. Parameter wegzulassen, die man bisher nur einmal gesehen hat, um genau diese Versuche zu stören, wäre jedenfalls kein Hexenwerk. Oder ich habe mir zu wenig Mühe bei der Auswahl der Plugins gemacht 😉

Conversions: Essig.

Das war klar und ist oben schon erwähnt: Man mag Ziele einrichten können, aber gepaart mit allen anderen Einschränkungen ist das wenig aussagekräftig. Zu klein erscheint die "Stichprobe", um daraus Rückschlüsse ziehen zu können, Transaktionen und Umsatz sind ohnehin unsichtbar. Und wenn bevorzugt mobile Ziele verfolgt werden, ist sowieso nichts zu sehen. Der ganze Bereich ist also i. d. R. vollkommen unbrauchbar.

Fazit: Alles Käse? Nicht unbedingt!

Kann man nun deswegen mit Nacho Analytics nichts anfangen? Nein, das wäre viel zu kurzsichtig gedacht. Ein großes Manko in diesem kleinen Überblick ist die Auswahl der Domain (ich hatte aber nichts "größeres" zur Hand), die Tatsache, dass es sich auch noch um eine für den deutschsprachigen Markt gemachte Domain handelt und der eher kurze Testzeitraum. Meint: Unter anderen Bedingungen kann im Einzelfall durchaus mehr an Vergleichbarkeit bzw. Qualität zusammenkommen. Schließlich bezahlt der eine oder andere ja auch deutlich größere Tickets beim vermutlichen Hauptwettbewerber SimilarWeb. Dummerweise kann ich keinen Vergleich zwischen SimilarWeb und Nacho Analytics anbieten, aber das wäre viel "fairer"... vor allem dann, wenn man als Benutzer des erstgenannten Dienstes darüber nachdenkt, das deutlich günstigere andere Angebot zu nutzen.

Einige der oben genannten Einschränkungen und Gründe für Unterschiede sind allerdings auch bei anderen Websites nicht zu verbessern, nur weil ggf. mehr Daten da sind. Die Lücken stecken wie beschrieben sowohl in der Erhebung und dann offenbar auch nochmal in der Aufbereitung bzw. Bereitstellung in Google Analytics.

So oder so ist das Marketing für Nacho Analytics für meinen Geschmack einfach zu weit von der Realität entfernt - was ich streng genommen auch schon vor diesem kleinen Test gewusst habe. Denn wenn man die hier nun doch recht ausführlich beschriebene Methode kennt, mit der die Daten erhoben werden, muss man mit realistischen Erwartungen an ein solches Produkt gehen. Problem: Das wird in den seltensten Fällen passieren. Wie viele Marketer treffen wohl gerade folgenschwere strategische und operative Entscheidungen, die auf Annahmen basieren, welche wiederum auf sehr wackeligen Nacho Analytics - Beinen stehen, nur weil man glaubt, in "das Analytics des Wettbewerbers" schauen zu können? Mir soll es wurscht sein. Und wenn Du tatsächlich bis hier durchgehalten hast: Dir jetzt auch 😉 Ich kündige nun schnell meinen Account, bevor die Kreditkarte leidet.