Start » Blog » Analytics / Measurement Protocol

22.12.2015

Vergleich: Serverseitiges Bot-Tracking mit Analytics vs. Logfile-Analyse

Das hier im Blog gezeigte Verfahren zum Bot-Tracking nutzt die gewohnten Reports aus Google Analytics, um mehr über Häufigkeit und Tiefe der Besuche von Bots zu erfahren. Um herauszufinden, wie zuverlässig diese Methode ist, habe ich - konzentriert auf Besuche des Googlebot - exemplarische Daten einer Website von zehn Tagen aus Analytics mit den passenden Serverlogfiles verglichen. Das Ergebnis: Es besteht weniger als 2% Abweichung zwischen den Ergebnissen.

Methode und Datenquellen des Vergleichs

Im Fall der serverseitigen Datensammlung wurden ausschließlich Besuche des Googlebots als eigenes Segment in einem Analytics-Profil betrachtet und der Seitenreport des betreffenden Zeitraums als Vergleichsbasis verwendet. Dabei wurde das Tracking nach der im oben verlinkten Beitrag gezeigten zweiten Variante durchgeführt und durch Anpassung des "Bot-Arrays" auf den Googlebot beschränkt (ohne Mediapartners und AdsBot).

Um die passenden Daten aus den Serverlogs zu extrahieren, wurden die Logfiles mittels Graylog ausgewertet. Eine passende Umgebung nebst kleiner Anleitung dazu hat Michael Janssen auf GitHub beigetragen. Die mittels Graylog aufbereiteten Daten wurden exportiert und mit den ebenso aus Analytics an Excel übergebenen Daten in einer Tabelle zusammengeführt. Mit etwas Excel-Salz werden die Seitenaufrufe pro Tag und deren Verteilung auf einzelne Seiten miteinander vergleichbar.

Importfehler = Messfehler

Es ist üblich, dass einzelne Einträge aus Logfiles nicht wunschgemäß verarbeitet werden können. Das war bei einigen Zeilen der Logs aus den untersuchten zehn Tagen - leider - ebenfalls so. Einige dieser fehlerhaften Zeilen betreffen vermutlich auch den Googlebot. Diese Fehler - und die relativ geringe Menge an Daten, die der wenigen Zeit geschuldet sind, die seit der Implementierung des serverseitigen Bot-Trackings auf meiner Domain vergangen ist - lässt die o. g. Zahl von 2% zurecht unsicher erscheinen. Ich war aber schlichtweg zu neugierig, um länger zu warten 😉 Ich werde den Vorgang noch einmal mit den Daten eines Quartals wiederholen. Sollten die Ergebnisse nennenswert abweichen, werde ich Details hier nachreichen.

Ergebnis im Detail

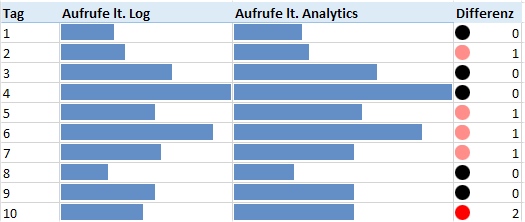

Der Vergleich zeigt Abweichungen von maximal einem oder zwei Seitenaufrufen bei insgesamt 54 vom Googlebot besuchten URLs. Die Auswertung zeigt nur 53 davon. Die Startseite wurde - zu Gunsten der Aussagekraft von Balkendiagrammen - bei der Visualisierung ausgeklammert. Im Vergleichszeitraum hat der Googlebot jeden Tag mehrere Seiten besucht. Insgesamt wurden in Analytics 165 Seitenaufrufe von Unterseiten und 67 Aufrufe der Startseite verzeichnet.

Die Besuche nach Tagen liefern in Summe eine übereinstimmende Anzahl an Hits. Allerdings liegt mal bei Analytics und mal im Logfile die Anzahl um einen, maximal zwei Hits höher. Eine Übereinstimmung in der Gesamtanzahl bedeutet, dass neben den potentiell fehlenden Hits in den ausgewerteten Logfiles (siehe oben) also gelegentlich auch Hits offenbar nicht in Analytics ankommen. Die Erklärung ist vermutlich die begrenzte Zeit, welche in das Absetzen der Messpunkte per Measurement Protocol beim serverseitigen Tracking investiert wird.

Auf Seitenebene ist das Bild ähnlich. Es gibt zwar Abweichungen von maximal zwei Hits pro Seite, dennoch sind in beiden Berichten jeweils alle betroffenen Seiten zu finden.

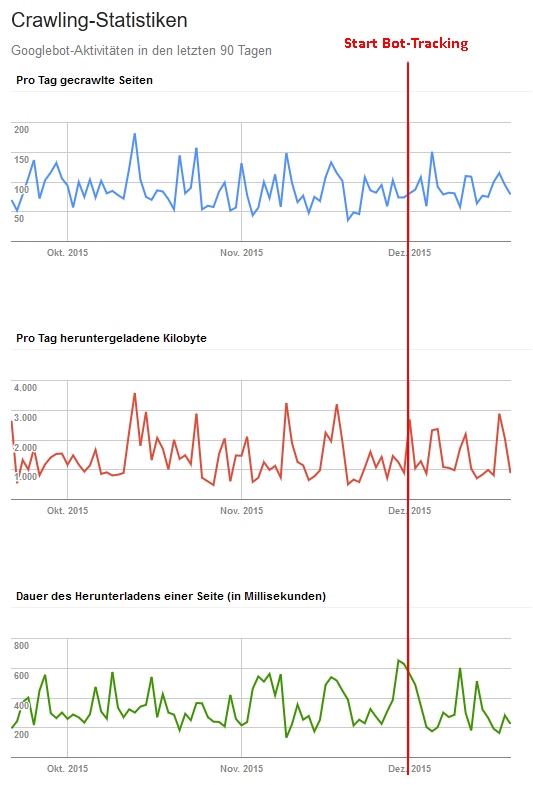

Stört das Tracking den Googlebot?

Eine Frage, die sich im Zusammenhang mit der theoretisch vergrößerten Latenz der eigenen Website durch das serverseitige Tracking stellt, ist die nach unerwünschten Nebenwirkungen auf das Crawlverhalten. Soweit sich dies aus den (mit den üblichen Schwankungen versehenen) Diagrammen der Google Webmaster Tools (na gut: Google Search Console) ablesen lässt, scheint dies nicht der Fall zu sein. Sowohl die Ladezeiten als auch die Anzahl der besuchten Seiten zeigen keinen erkennbaren Trend.

Fazit

Mit dem Tracking aller Bot-Aufrufe via Measurement Protocol in Analytics sind die im o. g. Beitrag genannten Fragen wie z. B. nach Besuchstiefe, Frequenz oder dem Verhalten auf Ebene einzelner URLs mit vergleichbarer Zuverlässigkeit zu beantworten, ohne sich den üblichen Mühen der Logfileanalyse zu unterziehen. Vertraute Reports und simple Drill-Down-Möglichkeiten in Google Analytics liefern einen detaillierten Blick auf das Verhalten des Googlebots, soweit es um die dabei erfassten Inhalte geht.

Selbst mit den Einschränkungen, die die Beschränkung auf "Contentseiten" aus dem CMS bei der vorgestellten Implementierung mit sich bringt, ist diese Methode m. E. eine sinnvolle (weil nach einmaliger Implementierung jederzeit verfügbare) Ergänzung zur üblichen Logfileanalyse. Diese spielt zwar in den Bereichen Fehler, Statuscodes und Ressourcen nach wie vor ihre Stärken aus, wird aber i. d. R. nicht so regelmäßig durchgeführt, wie es angebracht wäre. Ohne diese eher technische Ebene steht in der Analytics-Variante aber eigentlich alles zur Verfügung, was die typischen "Marketingfragen" im Zusammenhang mit dem Googlebot betrifft.