17.04.2021

W-Fragen in der Search Console mit RegEx

In der letzten Woche sind eine ganze Menge Artikel dazu erschienen, dass - und wie - man in der Google Search Console nun Reguläre Ausdrücke (kurz "RegEx") nutzen kann, um Daten wie URLs und Suchanfragen zu filtern. Warum also noch einer? Weil gerade das Beispiel der W-Fragen für alle SEOs, Content Marketer und andere einen hohen Praxisbezug hat und daher viele neue Passagiere auf den RegEx-Zug aufgesprungen sind. Um das Potential zu nutzen, sollte man die genutzten Lösungen a) grob verstehen und damit b) nach eigenen Anforderungen anpassen können. Genau das soll dieser Beitrag anhand eines konkreten Beispiels zeigen. Weiterlesen... »

10.09.2015

Google Search Console wird wieder in Webmaster Tools umbenannt

Jedenfalls bei mir. Ich kann mich mit dem neuen Namen nicht anfreunden. Weder in der Kommunikation mit anderen (auch wenn ich es muss), noch in Form des Anblicks bei der Verwendung der Webmaster Tools. Der Webmaster Tools. Webmaster Tools, nicht Search Console. Ich mag den Namen nicht. Hatte ich das schon erwähnt?

Name doof? Einfach umbenennen!

Ein Plugin war mir dann doch ein wenig zu übertrieben, aber da ich ohnehin gern und viel mit Greasemonkey bzw. Tampermonkey "nachbessere", habe ich zahllose schweißtreibende Stunden in eine umfangreiche Lösung investiert 😉

Wer meine Abneigung gegen den neuen Namen teilt, kann sich also mit den o. g. Erweiterungen für den Browser seiner Wahl Abhilfe verschaffen. Sowohl in der Anwendung als auch in der Hilfe. Einfach hier klicken und das Script in Greasemonkey oder Tampermonkey installieren oder herunterladen. Schon sieht das wieder so aus:

Wem es noch fehlt: Hier sind Greasemonkey für Firefox oder Tampermonkey für Chrome zu bekommen.

Happy Re-Rebranding & Webmaster-Tooling 😉

01.04.2015

Metatag rettet faule Webmaster vor Rankingverlust

Wenn Google am 21.4. ernst macht und alle Websites, die nicht als mobilfreundlich eingestuft werden, bei mobilen Suchen benachteiligt (mit mehr Auswirkungen "als bei Panda und Penguin zusammen"), werden eine ganze Menge Webmaster noch nicht fertig sein mit der Umstellung auf Responsive Design oder mit anderen Mitteln.

Da dies aber vor allem auch ein paar gaaanz große Fische betrifft, hat Google genauso erstaunlich schnell einen Rettungsanker für überlastete IT-Abteilungen nachgelegt, wie zuvor mit der Nennung eines konkreten Termins überrascht. Und so geht es: Wer nicht rechtzeitig fertig wird, aber bereits angefangen hat, kann Google dies per Metatag mitteilen und so Zeit zur Fertigstellung "erbitten".

29.03.2015

Mobile Search steigt auf in die erste Liga

Am 21. April ist #MobileDay. Wer bis dahin nicht (endlich) seine Hausaufgaben gemacht und seine Website auf Mobilfreundlichkeit abgeklopft hat, wird bei Suchanfragen, die auf Mobilgeräten stattfinden (Wachstum: schnell und unaufhaltsam), nicht mehr gefunden, weil die "mobilen Rankings" deutlich abfallen werden.

30.09.2014

Nachrichten aus Google Webmaster Tools für bereits entfernte Websites

Seit Monaten bekomme ich regelmäßig Nachrichten aus den Google Webmaster Tools für die Domain eines ehemaligen Kunden. Und ich werde sie einfach nicht los. Obschon ich die Domain schon aus meinen Webmaster Tools gelöscht habe. Dass ich damit nicht allein bin, merkt man schnell, wenn man sich mit passenden Suchbegriffen bei Google um Abhilfe bemüht: Alle paar Monate wird ein neuer Eintrag in einem der mal mehr und mal weniger passenden Google Produktforen gepostet.

Ein Tipp, den man häufig liest, ist "einfach die Mails ignorieren". Das würde ich auch gern, aber nun haben die Nachrichten eine neue Dimension erreicht. Nachdem es zunächst nur Meldungen gab, dass der Googlebot keinen Zugriff auf die Seite hat, dass sich die Fehler häufen und ähnlicher Kram, den man sich zuammenreimen kann, weil die Domain vom ehemaligen Betreiber zwischenzeitlich abgestoßen wurde, hatte ich kürzlich dieses Schätzchen im Posteingang:

04.06.2012

Analytics Content Experiments: (noch) schlechter Ersatz für Google Website Optimizer

Mit großem Trara beerdigt Google zum 1. August den Google Website Optimizer und bietet als Ersatz neue "Content Experiments" in Google Analytics an. Wer sich nur die Ankündigungs-E-Mail von Google dazu durchliest könnte meinen, es handelt sich um alten Wein in neuen Schläuchen und das Tool sei nur "umgezogen". Die dort verwendete Formulierung "To elevate website optimization and provide one fully integrated tool for testing, content optimization will now have a new home within Google Analytics." klingt ja auch vollmundig und lässt auf Umsetzung vieler Wünsche hoffen, die man ggf. bisher im Einsatz des Website Optimizers entwickelt hat.

12.03.2012

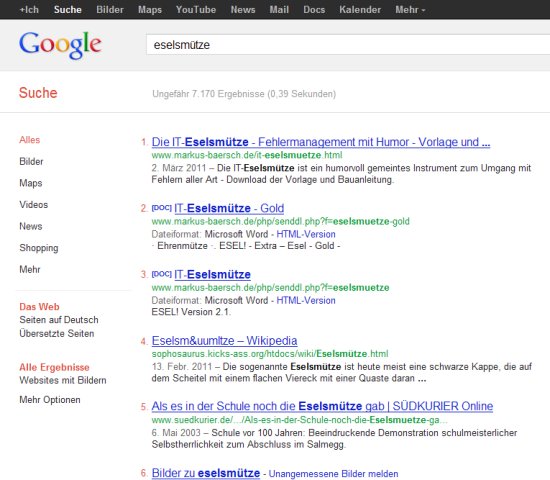

Nummerierte Google Suchergebnisse

Da ich gern 100 statt nur 10 Treffer bei Google erhalte, ist eine Nummerierung aus mehr als nur einem Grund sinnvoll - ob SEO oder nicht. Scripts und AddOns gibt es ja genug, die für Nummerierungen sorgen, aber die meisten machen auch noch eine ganze Menge anderen Kram, den ich eigentlich nicht will. Daher habe ich schon länger ein selbstgestricktes Script (in Firefox via Greasemonkey; in Chrome mit Tampermonkey) im Einsatz.

Damit ich es nicht ständig suchen muss, habe ich (angesichts der riesigen Reichweite dieses Blogs also hauptsächlich für mich selbst ;)) die akt. Fassung online abgelegt. Wer es nutzen mag, kann also Greasemonkey für Firefox oder Tampermonkey für Chrome installieren und dann per Klick das Script nachinstallieren: Nummerierte Suchergebnisse bei Google.

13.02.2012

Google Datenschutzbestimmungen: Nichts Neues!

Ja, Google hat seine Datenschutzbestimmungen vereinfacht. Und ja: Dabei sind auch ein paar Kleinigkeiten geändert worden. Aber das große Gejammer über die Konsolidierung von Nutzerinformationen über Produktgrenzen hinweg, über die sich derzeit auch in meinem privaten Bekanntenkreis überraschenderweise die Gemüter erhitzen, kann ich nicht nachvollziehen, denn das ist nun wirklich keine Neuigkeit.

Auch die vorher für jedes Produkt einzeln existierenden Nutzungsbedingungen haben stets darauf hingeweisen, dass sich Google diese Option offen hält. Dass man es jetzt... naja: ehrlicher formuliert und durch die Zusammenfassung der vielen einzelnen Dokumente mehr in den Fokus rückt, ändert nichts daran, dass Google schon immer ein nahezu zu 100% datengetriebenes Untermnehmen ist und sich die vielen "kostenlosen" Angebote schon immer mit den Daten der Nutzer hat bezahlen lassen, aus denen laufend Erkenntnisse gewonnen und oft auch neue Produkte gefüttert werden.

Da ist eine kostenlose Telefonauskunft, deren zahlreiche US-Nutzer dafür gesorgt haben, dass Google nun lebendige Sprache besser verstehen kann als Siri & Co. nur ein Beispiel von vielen. Google ist nicht kostenlos. Und das Interesse am einzelnen Nutzer ist durchaus vorhanden, wenngleich dieses (noch) etwas anderer Natur ist, als bei anderen Plattformen. Es geht hauptsächlich darum, jeden (möglichst regelmäßigen) Nutzer optimal mit Werbung zu beballern, denn da kommt (mal von Android abgesehen) das Geld her Wer damit wirklich ein Problem hat, war auch schon vor den geänderten Datenschutzbestimmungen gut beraten, sich bewußt zu machen, wann wo und wie Google überall Daten über Nutzer und Nicht-Nutzer (z. B. via Google Analytics) sammelt... und ggf. aktiv etwas dagegen zu tun, wenn er damit nicht einverstanden ist.

Einige Hilfsmittel bietet Google dazu selbst an - wohlwissend, dass die Mehrheit sich überhaupt keine Gedanken macht und der Großteil des Rests zwar gerne meckert, aber trotzdem kaum jemand die Plugins zum Ausstieg aus dem Tracking installiert oder den privaten Modus auch beim "normalen" Surfen aktiviert. Wer sich einen Überblick verschaffen will, findet bei Google eine übersichtliche Auflistung aller Datenschutztools. Und ich habe mit diesem Blogpost nun eine einfache Antwort auf eine derzeit recht beliebte Frage 😉

08.11.2011

Willkommen zur SSL-Volksverdummung. Danke Google!

Ich wollte eigentlich kein Wort drüber verlieren und habe es auch fast zwei Wochen geschafft. Aber nachdem ich nun den oberflächlichsten Verdummungbeitrag seit langem in der Webmaster Zentrale dazu gelesen habe, müssen ein paar Dinge einfach mal raus - egal, ob es wirklich jemand liest oder nicht.

30.09.2011

Einfachere Verifikation: Google Analytics und Webmaster Tools wachsen weiter zusammen...

Das scheint wohl schon länger so zu funktionieren, aber mir ist es erst jetzt aufgefallen: Wenn in den Google Webmaster Tools eine neue Site hinzugefügt werden soll, kann dazu nun einfach der Analytics-Trackingcode verwendet werden. Meint: Wer als Administrator beim passenden Analytics-Konto zur Website eingetragen ist, muss sich künftig weder als Agentur noch Betreiber mit Uploads, Metadaten oder gar DNS-Konfiguration rumschlagen.

Ich find´s praktisch. Die engere Verknüpfung beider Werkzeuge ist damit zwar nicht wirklich vorangetrieben, aber trotzdem eine große Hilfe. Wer weiß: Es mag ja auch was mit dem kommenden "Analytics Premium" zu tun haben;) Wenn man jetzt noch die neue "schöne" Startseite der WMT wieder auf eine übersichtlichere Listenansicht umstellen könnte. Aber ich habe ja immer was zu meckern...

16.09.2011

Schade: Google Page Speed Service kann nicht zaubern

Update: Der Page Speed Service wurde 2015 von Google eingestellt.

Wenn es um Websites geht, ist schneller immer besser. Ich bin daher auch ein großer Freund von PageSpeed, YSlow und anderen Werkzeugen zur Messung und Optimierung der Performance von Internetseiten... ohne nun wirklich immer alles ausreizen zu müssen, was drin steckt. Also definitiv nicht wie Scotty 😉

Das ist aber vielleicht trotzdem schon das Problem: Wenn ich mir verschiedene von mir betriebene oder betreute Sites anschaue, bringt eine "Faulenzer-Optimierung", wie sie von Google mit dem Page Speed Service zur dynamischen Optimierung der eigenen HTML-Seiten und Ressourcen angeboten wird, leider nicht sehr viel, wenn man sich selbst ein wenig Mühe gegeben hat. Klar: Ich betreue keine spiegel.de, aber trotzdem scheint es mir kaum ein Modell, mit dem Google wirklich viel ausrichten wird, um das Web schneller zu machen.

Das typische Bild bei einigermaßen "speedbewussten" Sites scheint ein minimaler Gewinn im einstelligen Bereich für Erstaufrufe zu sein. Bei erneuten Aufrufen ist allzu oft die Ladezeit sogar (wegen des Umwegs und der Bearbeitung auf dem Weg zum anfordernden Browser ja auch erklärbar) höher als ohne den Service.

Hier ein Beispiel für meine eigene Website: Der Effekt ist nicht der Rede wert. Wenigstens ist die Seite aber noch intakt - das hat bei anderen Versuchen schon anders ausgesehen, so dass das Ergebnis nach der Optimierung mitunter deutliche Darstellungsprobleme hatte.

Klar, dass es bei anderen Sites besser aussieht und der Gewinn größer ausfällt. Aber ich kann mir eigentlich nicht denken, dass ein Unternehmen, welches eine vergleichsweise langsame Website betreibt, wirklich den später ja kommerziellen Service nutzen und dauerhaft dafür zahlen wird, wenn es meistens mit ein paar mehr oder weniger kleinen Handgriffen und einmaligem Aufwand machbar ist, selbst eine ganze Menge für bessere Antwortzeiten zu tun. Oder mache ich es mir da zu einfach?

24.05.2011

Mehr Futter für den Feedreader: Offizieller Google Search Blog "Inside Search"

Wer sich - freiwillig oder aus beruflichem Druck - für die Google-Suche interessiert, sich bisher aber mit der Ausrede "das ist mir aber viel zu viel technisches Webmaster-Zeugs" oder ähnlich fadenscheinigen Aussagen davor gedrückt hat, die Google Webmaster Central oder den deutschen Ableger zu abonnieren, dem sind nun Argumente ausgegangen, denn Google betreibt jetzt unter Inside Search eine eigene Anlaufstelle für alles, was "direkt" mit der Suche zu tun hat. Das bedeutet nun aber ganz und gar nicht, dass man sich Webmaster Central nun sparen kann... sondern nur, dass man mit weiteren Kleinigkeiten versorgt wird, die hoffentlich nicht nur Anekdoten aus dem Leben des Search-Teams, sondern idealerweise auch Handfesteres zu bieten haben. Der vollmundige Eröffnungsbeitrag läßt da gleichermaßen hoffen und bangen... wir werden es ja erleben. Oder ertragen. Oder beides. 😉

12.05.2011

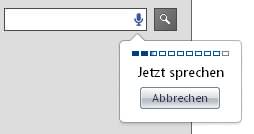

Google Chrome: Spracheingabe in Webformularen

Erst heute bin ich durch die zweite Google IO-Keynote darauf aufmerksam gemacht worden, dass Google Chrome es denkbar simpel macht, Spracheingabe in Eingabefeldern von Webformularen aller Art zu ermöglichen - genau so, wie man es bereits z. B. aus der "googlelabsfunktionsbereicherten" US-Google-Suche kennt.

Dazu reicht es, dem Eingabeelement ein simples "x-webkit-speech" mit auf den Weg zu geben. In der simpelsten Variante also einfach so:

<input type="text" x-webkit-speech>

Anhand der Suchfunktion auf dieser Website (allerdings aus langweiligen Gründen nicht im Blog) gezeigt sieht das so aus: Wer mit Chrome auf die Seite kommt, sieht das Aufnahmesymbol, das sich auch auf Android-Geräten zur Sprachsteuerung immer mehr breit macht. Olle Firefoxe oder andere Browser können damit allerdings noch nichts anfangen. Nicht mal mobil unter Android 2.3.4.

Ein Klick startet die Aufnahmefunktion, über die das Eingabefeld befüllt werden kann. Das klappt in Chrome genau so gut oder schlecht wie bei entsprechenden Funktionen auf dem Mobiltelefon: Die Spracherkennung selbst ist prima, allerdings eben leider (noch) nicht für längere Texte oder gar als Ersatz für "echte" Spracherkennungssoftware geeignet, weil z. B. keinerlei Großschreibung stattfindet (sicher übrigens ein Grund, warum sich Apple lieber - möglicherweise? - Nuance kauft bzw. schon gekauft hat, als das Thema nochmal selbst zu erfinden und dann gleich "perfekt" zu sein, wenn iOSxyz dann ebenso sprachbedienbar wird). Zur einfachen Texteingabe aber schon jetzt eine prima Sache. Wenngleich es hier bei der Suchfunktion zugegebenermaßen eher eine Spielerei ist.

Sobald sich die Funktion aber - mit verbesserter Erkennung und "lokalisierter" Schreibweise - auch in anderen Browsern breitmachen sollte (was sicher erst dann passiert, wenn genug Websites darauf setzen) und auch für große Textfelder (<textara>, nicht nur <input>) genutzt werden kann, kann vielleicht auch auf dem Desktop so manche Eingabe schneller per Stimme als mit der Tastatur erfolgen. Das wäre schon in gewisser Weise etwas Neues, denn bis jetzt muss man sich die Funktion, wenn gewünscht, per "Dragon Dictate" & Co. nachinstallieren.

04.03.2011

Man kann Google Webmastertools + Analytics verbinden... aber wozu?

Um die Frage gleich zu beantworten: Aktuell ist die Verknüpfung zwischen Webmastertools und Analytics eigentlich noch zu gar nichts gut. Aber das kann sich ja durchaus noch ändern... Speziell die Google Webmastertools haben sich in den letzten Monaten ja durch stetige kleinere und größere Verbesserungen hervorgetan. Da dort vor allem der Bereich der Analyse von Klicks und Impressions im Suchanfragenbericht immer hilfreicher wird, ist der Wunsch nach ähnlichen Reports direkt in Google Analytics nicht ungewöhnlich. Aktuell findet man aber nichts weiter als zwei sehr unspannende Links aus den WMT zu Google Analytics. Nichts in der anderen Richtung oder praktischere / engere Integration beider Produkte.

28.02.2011

Google CloudConnect: Google Docs als Backup + "Sharepoint Extralight"

Praktisch isses schon, wenngleich weder neu noch besonders "intergriert": Dank (Achtung - inzwischen eingestellt, siehe link) Google Cloud Connect (BTW: mal wieder ein suuuuuuper Name. Kann sich bestimmt jeder gleich was drunter vorstellen) kann man nun nicht nur den Office Live Workspace, sondern auch ein entsprechendes Google Pendant dazu nutzen, seine Dokumente direkt aus den beliebten Office-Programmen MS-Wurst, Echse & Bauernfreund mit der Wolke abzugleichen. Das sorgt dann nicht nur für ortsunabhängige Sicherheitskopien der Dokumente, sondern erlaubt auch die "Online-Zusammenarbeit" (im weitesten Sinne) mehrerer Autoren an einem Dokument.

Weiterlesen... »