17.03.2019

Chome Lite Pages und Analytics - ein Problem?

Kurze Antwort: Nein.

Warum ich mich das überhaupt gefragt habe? Weil laut der Beschreibung im Chromium Blog "Google Server" im Spiel sind (wie auch sonst), die die Seiten optimieren und faktisch in veränderter Form ausliefern. Aber: Tun Sie das wie ein Proxy oder CDN oder ändert sich - wie im Fall von AMP - etwas am Tracking und den Rahmenbedingungen wie dem Host, der URL der Seite etc?

Damit in diesem Blogbeitrag dennoch etwas mehr Nutzen herauskommt als die kurze Antwort oben, beschreibe ich kurz meinen Weg zum "Nein", denn das Debugging von mobilen Seiten in Chrome auf einem Android Gerät mag dem einen oder anderen in ähnlichen Fällen helfen. Weiterlesen... »

03.03.2019

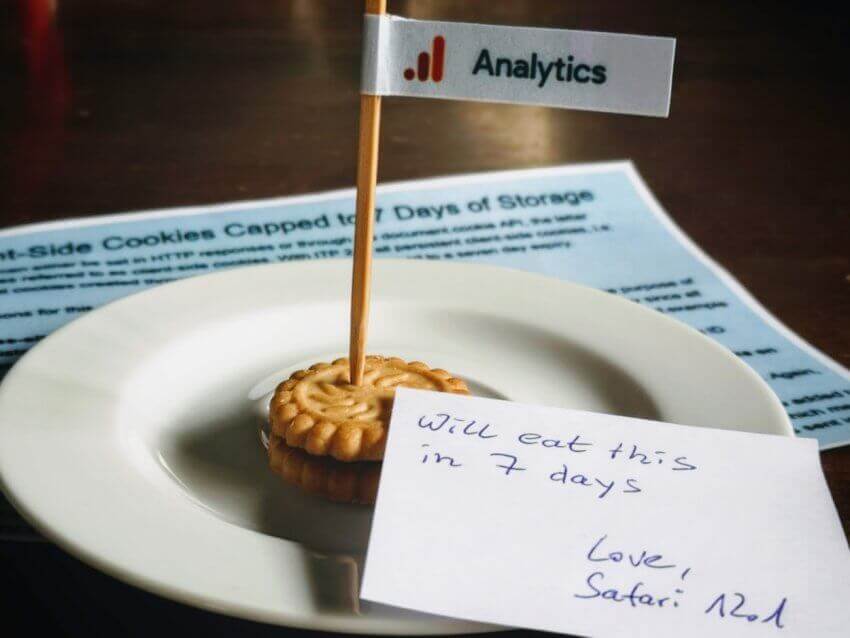

Wie ITP 2.1 Webanalyse bedroht, was man tun kann und ob man es sollte

ITP ("Intelligent Tracking Prevention") als Schutz vor Tracking durch Drittparteien und domainübergreifende Profilbildung in Safari Browsern ist prinzipiell eine gute Idee. Das sage ich selbst als jemand, der in der Rolle eines Marketers bei Google Ads & Co. auf so erhobene Daten in gewisser Weise angewiesen ist. Aber was Safari mit der neuen Version 2.1 von ITP einführen wird, geht deutlich über diese ursprüngliche Intention hinaus. Im Kern werden dabei First Party Cookies, wie sie für die Webanalyse (und deren Opt Out! - siehe unten), Testing, Personalisierung und viele andere Funktionen jenseits von Tracking durch Dritte oder Profilbildung genutzt werden, auf eine Lebensdauer von 7 Tagen begrenzt. Mit Folgen für alle o. a. Systeme. Das ist nicht gut. Was alles betroffen ist und was man tun kann, um die Effekte abzumildern, zeigt dieser Beitrag. Weiterlesen... »

27.01.2019

Neuer Check beim Analytrix-Audit: Doppelte Transaktionen

Die mehrfache Messung von Transaktionen in einem Shop kann mehrere Ursachen haben. Im einfachsten Fall wird die Bestätigungsseite eines Shops neu geladen und führt dann nicht zum leeren Warenkorb, sondern enthält nochmals alle Daten der Transaktion, die dann ein zweites Mal an die Webanalyse gesendet wird. Auch in AJAX-Checkouts kann es - vor allem im Zusammenspiel mit dem Google Tag Manager - schnell passieren, dass Transaktionen mehrfach gemessen werden. Weiterlesen... »

21.09.2018

Nacho Analytics: Same Shit, Different Can

Als ich vor ein paar Wochen erstmals den Namen "Nacho Analytics" gehört hatte, bin ich sowohl neugierig als auch skeptisch geworden. Das Tool verspricht dem Nutzer, in "jedermanns Analytics" schauen zu können. Einfach so. Revolutionäre Idee, mega-innovativ, Blabla.

Zugegeben: Kaugummigestützt aus "Not Your Analytics" ein "Nacho Analytics" zurechtzunuscheln, ist schon mal eine kreative Idee (die nur ein Amerikaner haben konnte). Und die verfügbaren Daten in Analytics zu versenken, klingt im ersten Moment auch nicht dumm. Aber steckt mehr dahinter, als durch pluginverseuchte Browser gesammelte Daten wie im Fall von SimilarWeb? ich wollte es wissen und habe nach längerer, durch gutes Marketing und schlechte Skalierung beim Anbieter ausgelöster Wartezeit einen kurzen Test gemacht, um mir einen Eindruck zu verschaffen. Weiterlesen... »

23.08.2018

Update zur "Analytics Referrer Spam Studie"

Anfang des letzten Jahres habe ich unter der Überschrift "ist Spam besiegt?" erstmals Zahlen zum Volumen von Spammern und Opfern, dem Anteil von Spam im Verweistraffic und der zeitlichen Entwicklung von Spam in Google Analytics veröffentlicht. Die Zahlen basierten auf der massenhaften Auswertung der Verweise für alle mir zur Auswertung selbst zur Verfügung stehenden Analytics - Properties von eigenen Websites und den Sites betreuter Kunden.

Diese Untersuchung habe ich seitdem monatlich fortgeführt. Zudem habe ich vor einiger Zeit damit begonnen, den Anteil an Spam im Verweistraffic als Event zu messen, wenn eine Spamanalyse mit Analytrix durchgeführt wurde - freilich ohne Bezug zur untersuchten Property oder gar Domain; nur den ermittelten Gesamtanteil an Spam, um eine von "meinen" Daten unabhängigere Messung zu ermöglichen. Hier nun zu beiden Methoden ein paar Zahlen als Update zur "Studie" aus dem letzten Jahr. Weiterlesen... »

04.07.2018

Organische Besucher im Griff - Eine Abkürzung für Google Analytics

Kommen Besucher über Google oder Bing auf die eigene Website, ist dies in Google Analytics problemlos dem Kanal des organischen Traffic zuzuordnen. Und auch für viele andere Suchmaschinen funktioniert dies - die Liste der unterstützen Quellen ist lang... leider aber auch sehr alt. Schon bei den internationalen Fassungen von Yahoo hört der Spaß auf und lokale Quellen wie Suchfunktionen bei T-Online oder web.de landen ohne Eingriff in die Konfiguration im falschen Topf. Dieser Beitrag zeigt eine Lösung, die mit einmaligem und überschaubarem Aufwand für eine Korrektur sorgt.

Weiterlesen... »

02.07.2018

Absprungrate und Verweildauer aus Sicht der Google SERPs in Analytics messen

So sperrig, wie der Titel es vermuten lässt, ist das Thema diesmal wirklich. Mir ist aufgefallen, dass ich die Anleitung zur Messung eines Teils der vielzitierten "User Signals" aus "Sicht" der Google Suchergebnisse bisher noch nicht verbloggt habe, sondern diese nur in Form der Session - Folien zur CAMPIXX 2018 (ab Folie 31) zu haben ist. Da hier die fehlende Tonspur eine eigene Umsetzung nicht wirklich einfach macht, liefere ich diese hier für alle nach, die das erweiterte Rezept zur Messung der SERP Bounce Time von Simo Ahava selbst implementieren wollen. Weiterlesen... »

01.07.2018

Exit Intent mit Google Analytics messen

Exit Intent Banner sind nicht immer und überall eine gute Idee. Dennoch mag es im Einzelfall zumindest sinnvoll sein, den Versuch des Verlassens einer Seite in der Webanalyse zu vermerken. Und sei es nur zur "Verbesserung" der Messung der Verweildauer auf einer Landingpage... solange es dann wenigstens als Ersatz für stumpf implementiertes und gern direkt schon beim Seitenaufruf erste Events feuerndes Scrolltracking dient 😉

Weiterlesen... »

07.04.2018

Auswirkungen von Javascript-Crawlern mit Rendering auf Google Analytics

Auf der CAMPIXX habe ich in Diskussionen im Anschluss an mehrere Sessions gehört, dass die Untersuchung der eigenen Website mit Tools wie dem Screaming Frog SEO Spider zunehmend Spuren in der Webanalyse hinterlässt, seit deren Crawler in der Lage sind, nicht nur den Quelltext einer Seite herunterzuladen und zu analysieren, sondern auch wie ein normaler Browser zu rendern. Ganz nach dem Vorbild von Google.

Aber stimmt das wirklich? Als “Webanalyse-Spam-Fan” bin ich darauf natürlich angesprungen und wollte es genauer wissen. Für eine Antwort muss also überprüft werden, ob sich in Google Analytics Hits nachweisen lassen, die durch Crawl-Vorgänge mit gängigen SEO- und OnPage-Tools entstehen, wenn deren Crawler die untersuchten Seiten auch rendern und nicht nur den Quellcode abrufen. Weiterlesen... »

16.03.2018

Kostenloser PII Datenschutz Check für Google Analytics

Personenbezogene Daten wie Namen, Mailadressen, Anschriften etc. (AKA "PII" - Personally identifiable information) haben in Google Analytics nichts verloren. Das ist nicht erst seit der kommenden DSGVO so - aber viele Benutzer von Analytics kümmern sich gerade jetzt (leider) zum ersten Mal um das Thema. Davon inspiriert habe ich bei Analytrix einen neuen Datenschutz-Check umgesetzt, mit dem jeder nach Autorisierung des Zugriffs für das Tool anhand verschiedener Muster in seinen Daten nach Spuren von problematischen Hits suchen kann.

Weiterlesen... »

05.02.2018

Eigene Besuche auf WordPress - Sites in Analytics ausschließen. Mit kleinen Extras

Knapp 40% aller Websites weltweit werden mit WordPress betrieben. Deren Betreiber nutzen in großer Anzahl Google Analytics zur Auswertung des Besucherverhaltens. Kein Wunder also, dass es zahlreiche Plugins rund um Integration, Reporting, Verfeinerung der Messung durch Events, E-Commerce-Transaktionen etc. gibt. Das Angebot wird dünner, wenn man sich um hiesige Besonderheiten wie IP-Anonymisierung, erweiterte Opt-Out-Funktionen oder den Dank der Anonymisierung nicht mit den üblichen IP-Filtern zu erledigende Ausschluss interner Besucher geht. Daher müssen wir uns auf verschiedenen Umwegen um Kennzeichnung interner Besucher bemühen, damit es etwas zu filtern gibt. Einen Überblick über einige Lösungen habe ich vor einiger Zeit unter www.gandke.de/ga-marker veröffentlicht, wo es auch einige Plugins für verschiedene Systeme - einschließlich WordPress - gibt.

Anreicherung des dataLayer für WordPress-Sites

Für eine vergleichsweise "kleine" Website mit einem oder wenigen Webmastern/Autoren habe ich im Sinne einer möglichst simplen Lösung ein weiteres Plugin erstellt, das im Zusammenspiel mit dem Google Tag Manager die Markierung anhand des Anmeldestatus ermöglicht. Davon ausgehend, dass i. d. R. genau dann viel "Datenmüll" entsteht, wenn man an der eigenen Website arbeitet und sonstige Aufrufe eher nicht ins Gewicht fallen, reicht dieses Merkmal vollkommen aus, um überflüssige selbstgemachte Hits ausreichend gut aus der Webanalyse zu filtern. Nebenbei wird der dataLayer des Tag Managers um ein paar weitere Informationen wie Autor, Monat und Jahr des Beitrags, Kategorien und Tags angereichert, um diese ebenfalls z. B. als benutzerdefinierte Dimension an Google Analytics zu senden.

Weiterlesen... »

15.09.2017

Supermetrics oder Data Studio? Beides.

Mit Supermetrics für Google Drive lassen sich Daten aus Analytics und anderen Quellen in Google Drive nutzen. Als ich zum ersten Mal darüber gestolpert bin, habe ich mir die Funktionen angesehen, ein paar Daten aus verschiedenen Quellen abgerufen und nach Ablauf der Testphase entschieden, dass es auch ohne geht. Das stimmt auch... jedenfalls für die meisten Fälle. Für Google Analytics, die Search Console gibt es AddOns für Google Drive (GA AddOn bzw. Search Analytics for Sheets) und für Google AdWords gibt es Wege wie AdWords Scripts, um Daten für manuelle oder automatisierte externe Weiterverarbeitung in Google Drive zu bekommen.

Spätestens seit dem Start des Google Data Studio hatte ich Supermetrics mehr oder weniger komplett vom Schirm verloren, wenn es um Reporting, Dashboards o. Ä. geht. Im Einsatz blieb es nur in Projekten, bei den Datenquellen relevant sind, die das Data Studio bisher nicht abgedeckt hat. Wozu also Supermetrics? Hier ein paar Argumente:

08.08.2017

Medium für Suchmaschinentraffic per Analytics-Filter korrigieren

Von einem aufmerksamen Anwender wurde ich darauf hingewiesen, dass nicht alle Konfigurationen für die Quellen der organischen Suche, die bei Analytrix in der Verweistraffic-Analyse untersucht werden, zum gewünschten Ergebnis führen. Während ich mir bei DuckDuckGo nicht sicher bin, ob es jemals anders war, habe ich beim Check zumindest für ecosia.org und ein paar andere Einträge festgestellt, dass sich das Verhalten der Suchmaschinen offenbar seit Erstellung der Liste im vergangenen Jahr geändert hat: Der Suchparameter schafft es nicht mehr bis in die Webanalyse und so ist eine Auswertung als Suchmaschine nicht (mehr) in allen Fällen möglich. Abhilfe schaffen erweiterte Filter auf der Arbeitsdatenansicht.

Weiterlesen... »

17.03.2017

Aktualisierte Spam-Domainliste für analytrix.de

Wer in den letzten Wochen bereits über den Spam-Check bei analytrix.de gestolpert ist, sollte die Analyse noch einmal wiederholen. Denn die Liste der Spam-Domains wurde deutlich erweitert.

Durch den sehr hilfreichen Analytics-"Megapost" von Alexander Holl bei 121WATT bin ich auf eine umfangreiche Referrer-Blacklist gestoßen (Update 10/2017: Tool inzwischen eingestellt), mit deren Daten ich die eigene Spam-Domain-Liste um knapp 150 neue Einträge erweitert habe. Da diese die Basis des Spam-Checks bildet, finden sich nun je nach Property deutlich mehr potentielle Spammer als vorher. Weiterlesen... »

13.02.2017

Ist Analytics Spam besiegt?

Nachdem Analytics Spam in einigen Konten Ende des letzten Jahres deutlichen Aufwind zeigen konnte, während andere Analytics-Benutzer einen deutlichen Rückgang oder gar komplettes Ausbleiben von Spam beobachtet haben, ist es nach der Welle von unerwünschten Nachrichten rund um das Finale des US Wahlkampfs offenbar allgemein ruhiger geworden.

Da ich in anderem Zusammenhang wieder über das Thema gestolpert bin, wollte ich herausfinden, ob sich ein allgemeiner Trend auch anhand von Daten belegen lässt. Aus verschiedenen Gründen ist die Klassifizierung von Webanalyse-Spam in "normalen" Google Analytics Konten ohne entsprechende Filter und gesonderte "Spam-Datenansichten" zwar nicht einfach bzw. besonders zuverlässig, aber dennoch wollte ich zumindest wissen, ob sich eine grobe Richtung erkennen lässt.